SSRって、結局SEOにいいの?っていう話

最近よく聞かれるのが、「SSR(サーバーサイドレンダリング)って、SEOに本当に効くんですか?」っていう質問。正直、これ、結構奥が深い話なんですよね。ReactとかVue.jsみたいなモダンなJavaScriptフレームワークでサイト作るのが当たり前になったけど、それが原因で「Googleにうまく認識されてないかも…」って不安に思う人が増えてる感じがします。

昔ながらのWebサイトは、サーバーがHTMLを作ってブラウザに渡す、というのが基本でした。これがまさにサーバーサイドレンダリングです。 でも、最近のWebアプリは、まず空っぽのHTMLとJavaScriptだけをブラウザに送って、ブラウザ側で画面を作り上げる「クライアントサイドレンダリング(CSR)」が主流になりました。 アプリみたいなリッチな動きができるのは、このおかげなんです。

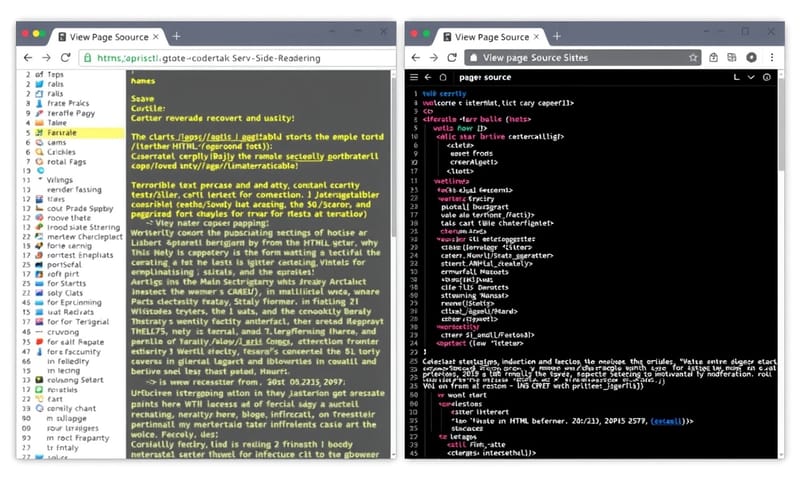

でも、ここにSEOの落とし穴がある。Googleのクローラー(Googlebot)がページに来たとき、CSRのサイトだと最初は中身がからっぽに見えちゃうことがあるんです。 もちろん、今のGoogleは賢いので、JavaScriptを実行してコンテンツを読み取ろうとします。 でも、それが100%完璧かというと、そうでもない。 時間がかかったり、途中でエラーが起きたりする可能性もゼロじゃない。そこで「じゃあ最初からサーバー側で完成品のHTMLを渡せば、クローラーも迷わないよね」っていう考え方、それがSSRなんです。

で、SSRのSEO上のメリットって具体的には何?

一番大きいのは、やっぱりクローラーがコンテンツを確実かつ迅速に認識できること。 Googlebotがページに来た瞬間に、完成されたHTMLがそこにあるわけですから、テキストやリンクをすぐに見つけてインデックス(データベースに登録)してくれます。これがCSRだと、GooglebotはわざわざJavaScriptを実行してレンダリングするっていう一手間が必要になる。 これを「レンダリングキュー」に入れる、みたいな処理が走るんですけど、サイトの規模が大きかったり、JavaScriptが複雑だったりすると、後回しにされちゃう可能性もあるわけです。

GoogleのMartin Splittさんも、CSRが正しく実装されていれば問題ないとしつつも、SSRの方がより堅牢なソリューションだと示唆しています。 結局のところ、Googleのリソースを無駄遣いさせない、親切な設計がSSRだと言えるかもしれません。クロールの効率が上がれば、サイト全体の評価にも繋がりやすくなりますからね。

もう一つのメリットは、ユーザー体験の向上、特に初期表示速度です。 SSRだと、サーバーから完全なHTMLが送られてくるので、ユーザーの画面にコンテンツが表示されるまでの時間が短くなります。 これって、Core Web VitalsでいうところのLCP(Largest Contentful Paint)の改善に直結します。表示が早いサイトはユーザーが離脱しにくいし、Googleもそういうサイトを高く評価する傾向にあります。 だから、間接的にSEOに良い影響を与える、というわけですね。

レンダリング方式、どれを選ぶ?それぞれの長所と短所

SSRが万能薬かっていうと、そうでもない。実は、他にもSSG(静的サイト生成)やISR(インクリメンタル静的再生成)といった選択肢もあって、それぞれに得意なこと、不得意なことがあります。 ここでちょっと、それぞれの特徴を僕なりの言葉で整理してみますね。

| 方式 | 良いところ(個人的感想) | イマイチなところ(注意点) |

|---|---|---|

| CSR (クライアントサイド) | ・サーバーが楽で安い ・Webアプリらしいぬるぬるした操作感を実現しやすい |

・初期表示が遅い ・SEO的には一番不利。Google任せになっちゃう |

| SSR (サーバーサイド) | ・SEOに強い。クローラーに優しい ・ユーザーが感じる表示速度が速い |

・サーバー代がかかる。負荷も高い ・後述する「ハイドレーション」が厄介 |

| SSG (静的サイト生成) | ・とにかく表示が爆速 ・セキュリティ的にも堅牢 ・ブログやドキュメントサイトなら最強 |

・ページ数が多いとビルド時間が地獄 ・動的なコンテンツは苦手 |

| ISR (インクリメンタル静的再生成) | ・SSGの速さとSSRの動的さをいいとこ取りした感じ ・「数分おきに更新」みたいな用途に最適 |

・キャッシュの制御がちょっと複雑になる ・まだ比較的新しい技術で、知見が少ないかも |

実装時の落とし穴:「ハイドレーション」とINPの問題

SSRを導入すれば万事解決!…とはならないのが、この世界の難しいところ。SSRには「ハイドレーション」という特有の概念があって、これが結構なクセモノなんです。

ハイドレーションをざっくり説明すると、「サーバーが作った見た目だけのHTML(静的)に、ブラウザ側でJavaScriptを結びつけて、インタラクティブ(動的)な状態にする処理」のこと。 SSRで表示されたページは、一見すると完成しているように見えます。でも、このハイドレーションが終わるまでは、ボタンをクリックしても反応しない「見かけ倒し」の状態なんです。

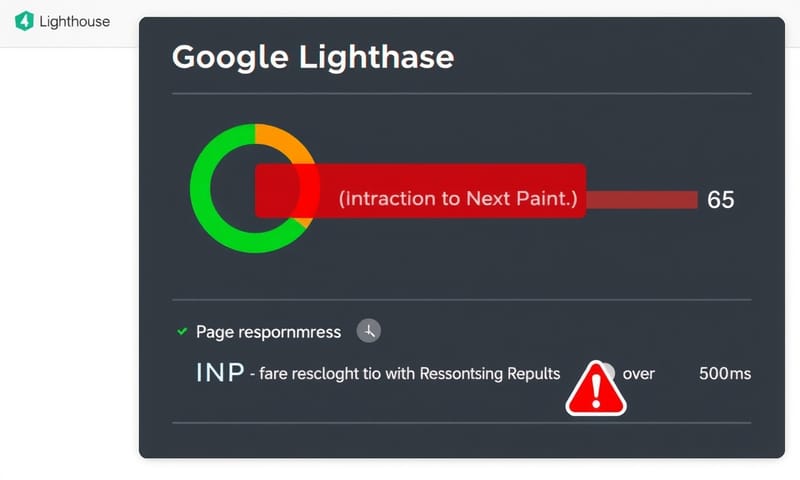

この「見かけ倒し」の時間が長いと、ユーザーは「あれ?動かないじゃん」ってなって、体験を損ないます。そして、これが最近Core Web Vitalsの仲間入りをした「INP(Interaction to Next Paint)」という指標に悪影響を与える可能性があるんです。 INPは、ユーザーがクリックなどの操作をしてから、画面に次の変化が起こるまでの応答性を測る指標。 ハイドレーション処理が重いと、この応答性が悪化してしまうわけです。 Next.jsみたいなフレームワークを使っていると、このハイドレーションエラーに遭遇することも少なくありません。

もう一つのデメリットは、サーバーの負荷とコスト。 ユーザーがアクセスするたびにサーバー側でページを生成するので、当然サーバーのリソースを消費します。 アクセスが集中すると、表示が逆に遅くなったり、サーバーがダウンしたりするリスクもある。だから、ただ導入すればいいというものではなく、適切なサーバー構成やキャッシュ戦略もセットで考えないといけないんです。

じゃあ、結局どうすればいいの?

ここまで読んで、「結局、SSRは使った方がいいの?悪いの?」って混乱してるかもしれませんね。結論から言うと、「サイトの特性による」としか言えません。

- ニュースサイトやECサイト、メディアサイトのように、コンテンツが頻繁に更新されて、かつSEOが非常に重要な場合は、SSRが強力な武器になります。

- ブログや企業のコーポレートサイト、ドキュメントのように、更新頻度がそれほど高くないなら、表示速度と運用コストの面でSSGが最適解になることが多いです。

- 管理画面やログイン後のダッシュボードのように、SEOを気にする必要がなく、リッチな操作性が求められる場合は、無理にSSRにせずCSRのままでも全く問題ありません。

大切なのは、それぞれのレンダリング方式のメリット・デメリットをちゃんと理解して、自分のプロジェクトに合ったものを選ぶことです。 Next.jsやNuxt.jsのようなモダンなフレームワークは、SSRだけでなくSSGやISRも同じプロジェクト内でページ単位で使い分けられるようになっているので、柔軟に対応できるのが強みですね。

Googleの考え方も変化しています。昔は「JavaScriptはSEOに不利」と言われていましたが、今ではGooglebotのレンダリング能力もかなり向上しています。 2025年以降のSEOでは、E-E-A-T(経験、専門性、権威性、信頼性)といったコンテンツの質そのものが、より重要視される流れになっています。 テクニックにこだわりすぎるより、まずはユーザーにとって価値のある、独自性の高いコンテンツを作ることが大前提。その上で、そのコンテンツを最も効果的に届けるための手段として、SSRやSSGといった技術を選択するというスタンスが、これからは大事になってくるんじゃないかな、と個人的には思っています。

この記事を読んで、あなたのサイトはどのレンダリング方式が一番合っていると思いましたか? もしよければ、コメントであなたのサイトの種類と、どの方式を選ぼうと思っているか教えてください!