まず結論。構造化データって何?

うーん、構造化データね…。 よく聞かれるけど、要するに、ウェブページに書かれている情報が「何なのか」を検索エンジンに教えるための「注釈」みたいなもの。 ただのテキストじゃなくて、「これは記事のタイトル」「これは商品の値段」って、意味をタグ付けしてあげる感じ。

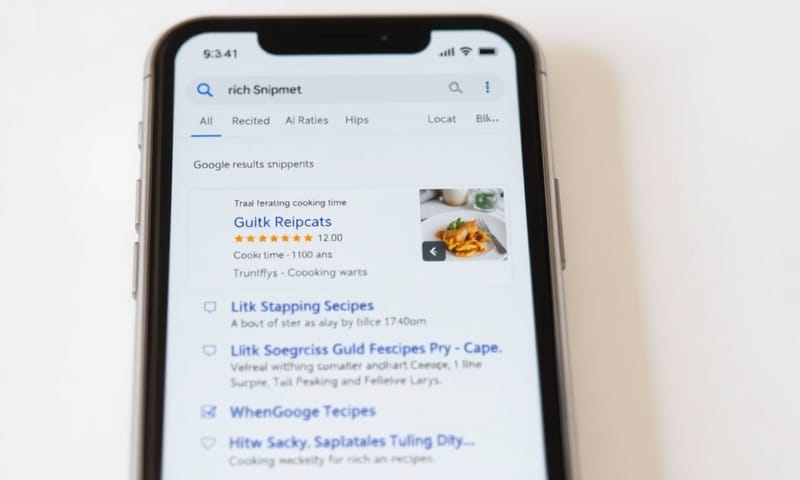

これの目的は、Googleとかの検索ロボットがページの内容を正確に理解できるようにするため。 そうすると、検索結果でちょっと豪華な表示(リッチリザルト)が出たりする。 でも、あれはあくまで結果の一つ。本質は、情報の意味を正しく伝えることにあると思う。

なんで今さら構造化データが重要なのか

昔からある技術だけど、最近また重要度が上がってる気がする。 なんでかっていうと、AI検索とか音声検索が増えてきたから。 「新宿の美味しいラーメン」って検索した時に、AIが「この記事はラーメン店のレビューで、評価は4.5、場所はここ」って理解してないと、まともな答えを生成できない。 つまり、これからの検索は、人間だけじゃなくAIにも分かりやすいページ作りが大事ってこと。

Googleも公式に導入を推奨してるしね。 ランキングに直接影響するわけじゃないって言うけど、クリック率が上がったりするのは事実だし。 間接的には十分SEO効果があると言えるんじゃないかな。

実装方法:今はJSON-LD一択でOK

実装のフォーマットはいくつかあるけど、もう今はJSON-LDを覚えておけばいい。 Googleもこれを推奨してる。 HTMLとは別の場所に

昔はMicrodataっていう、HTMLタグに直接書き込む方式もあったけど、あれはコードがごちゃごちゃして見づらくなるのが欠点だった。 WordPressの古いテーマとかだと、まだ残ってるかもしれないけど、新規でやるならJSON-LDで間違いない。

| フォーマット | 個人的な感想・使いどころ | |

|---|---|---|

| JSON-LD | 今の主流。Googleもこれが好き。 HTMLと分けて書けるから管理が楽だし、後から追加・修正するのも簡単。CMSとの相性も良い。迷ったらこれ。 | |

| マイクロデータ (Microdata) | 昔はよく見たやつ。HTMLタグに直接`itemscope`とか書く。ごちゃごちゃするんだよな、正直…。 既存の古いテーマとかだと、まだこれが入ってるかも。 | |

| RDFa | …これはもう、忘れていいんじゃないかな。学術的な背景はあるけど、Webマーケティングの現場ではまず見ない。 考えるだけ時間の無駄かも。 |

具体的な書き方は、まず自分のページに合った「タイプ」をSchema.orgで探すところから始まる。 例えば、ブログ記事なら`Article`や`BlogPosting`、商品ページなら`Product`、会社概要なら`Organization`といった感じ。 Googleの検索セントラルに、それぞれのタイプで推奨されるプロパティ(項目)が載ってるから、それに沿って必要な情報を埋めていけばいい。

実装したら必ずテストする

書いたら終わりじゃなくて、必ずテストが必要。 Googleが「リッチリザルト テスト」っていうツールを無料で提供してるから、それで確認する。 URLを入れれば、構造化データが正しく認識されてるか、エラーや警告がないかチェックしてくれる。

よくある間違いは、カンマ`,`や括弧`{}`の抜け漏れ。 ちょっとした構文ミスで全体が認識されなくなるから、ツールでの確認は必須作業。 あと、海外のSEOツールだけど、Bingの検証ツールとかもたまに使うと、違う視点でチェックできるかも。

よくある誤解と注意点

最後に、よく勘違いされてる点をいくつか。ここが一番大事かもしれない。

一つは、「とりあえずたくさん情報を詰め込めば良い」という誤解。これは違う。 マークアップする内容は、実際にユーザーがページ上で見れるコンテンツと一致してないといけない。 隠しテキストをマークアップするのはスパム行為と見なされる可能性があるから絶対にダメ。 Googleの品質に関するガイドラインでも、この点は厳しく言われている。

もう一つは、「マークアップすれば必ずリッチリザルトが出る」というものでもないこと。 あくまでGoogleのアルゴリズムが「ユーザーにとって有益」と判断した場合に表示されるだけ。 だから、表示されなくてもがっかりしないこと。

あと、意外と見落としがちなのが、画像のURL。構造化データ内で指定する画像は、ちゃんとGoogleがクロールできる状態じゃないとダメ。 robots.txtで弾いてたりすると表示されない。

日本のサイトだと、特に`FAQPage`(よくある質問)や`Article`(記事)を実装するケースが多いけど、海外のECサイトなんかを見ると、`Product`スキーマに`shippingDetails`(配送情報)とか、もっと細かい部分まで作り込んでる。 Googleの公式ドキュメントはグローバル基準で書かれてるけど、日本のWeb担当者フォーラムとかのブログ記事を見ると、もっと日本市場に特化した使い方のヒントが見つかることもある。 両方見比べるのがおすすめ。

結局のところ、構造化データは「検索エンジンとの対話」みたいなもの。 正確で、正直な情報を伝えることが、長い目で見れば一番のSEOになるんだと思う。

あなたのサイトではどうですか?

ちょっと考えてみてほしいんだけど、あなたのサイトで一番効果がありそうな構造化データって何だと思いますか? 記事ページの「Article」、商品ページの「Product」、それとも「FAQPage」? もしよかったら、コメントで教えてください。