えーっと、サイトリンクね…これ、よく聞かれるんだけど、なんていうか、直接いじれないのがもどかしいよね。うん。今日のテーマは、これ。サイトリンクについて、ちょっと思うところを話してみようかなと。

まず結論から言うと

えーっと、まず結論から言うと、サイトリンクはGoogleが自動で出すもので、僕らが直接コントロールすることは、まあ、できない。 これが大前提。でも、表示されやすくなるように「仕向ける」ことはできる、っていうのが、まあ、現実的な答えかな。これを狙ってやるっていうよりは、サイトをちゃんと作ったら、結果としてついてくる、みたいなイメージ。うん、そんな感じ。

サイトリンクって、そもそも何?

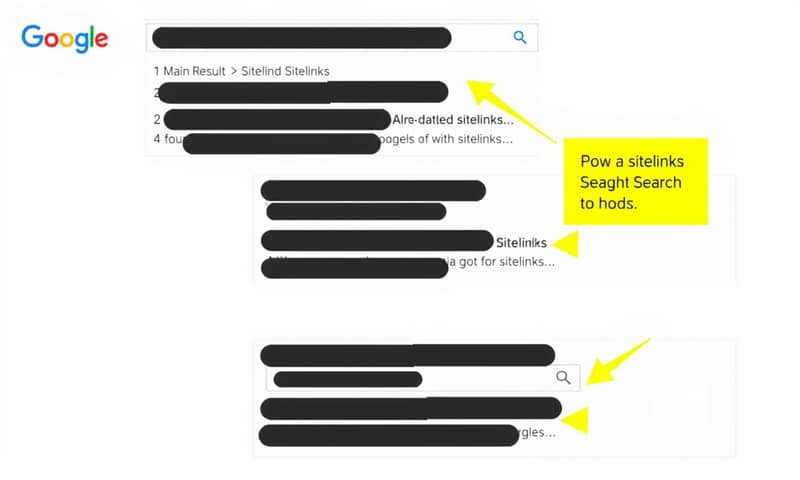

ああ、一応ね、うん。サイトリンクっていうのは、検索結果で、あの、メインのタイトルの下にずらっと並んでるリンクのことね。見たことあるでしょ? 会社名とか、サービス名で検索したときによく出るやつ。 あれがあると、ユーザーはトップページを経由しないで、直接「料金プラン」とか「お問い合わせ」のページに行けるから、便利なんだよね。 サイト運営者側からしても、検索結果での占有スペースが広くなるから、目立つし、クリックされやすくなるっていうメリットがある。 まあ、いいことづくめに見えるんだけどね。

じゃあ、どうやって表示を「狙う」の?

コントロールはできないけど、Googleに「ここ、重要ですよ」って伝える方法はいくつかある。僕がいつも意識してるのは、だいたいこんな感じかな。

-

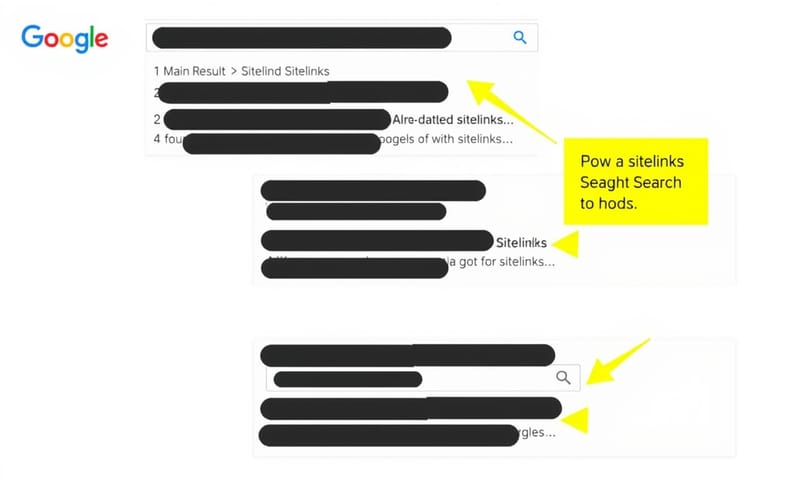

サイトの構造を分かりやすくする、かな。…なんていうか、人間が見ても、Googleが見ても迷わないような。 例えば、トップページから大事なページにちゃんとリンクが張られてて、階層が深くなりすぎてない、みたいな。基本的なことだけど、これが一番効く気がする。

-

内部リンクの貼り方を工夫する。重要なページには、他のページからもちゃんとリンクを貼ってあげる。アンカーテキスト、つまりリンクの文字も大事。「詳しくはこちら」じゃなくて、「〇〇の料金プラン」みたいに、具体的に書く。これも基本だね。

-

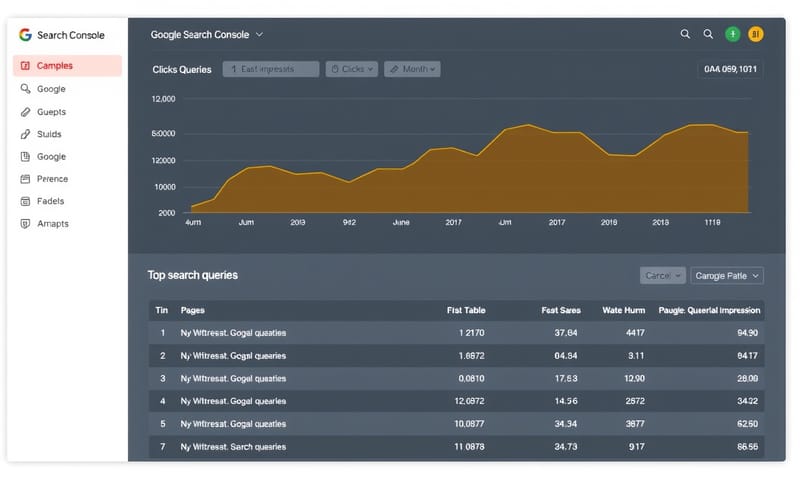

XMLサイトマップを送信する。これはもう、やってて当たり前なんだけど。Googleに「うちのサイトにはこういうページがありますよ」っていう地図を渡すイメージ。 これでサイトリンクが保証されるわけじゃないけど、Googleがサイトを理解する手助けにはなる。

-

ページタイトルを簡潔で分かりやすくする。「会社概要|株式会社〇〇」みたいに、ページの役割がすぐわかるタイトルをつけること。 Googleもユーザーも、タイトルを見て中身を判断するからね。

要するに、小手先のテクニックじゃなくて、ユーザーが使いやすいサイトを作ることが、結果的にサイトリンクにつながるってことだね。 Googleが言ってる「ユーザーにとって有益かどうか」っていうのは、まさにこれだと思う。

昔はできたけど今はできないこと

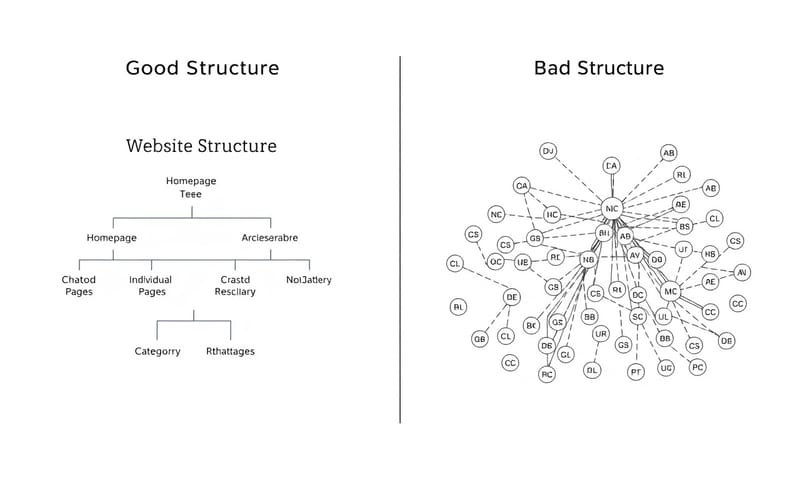

これ、知らない人もいるかもだけど、昔はSearch Consoleで「このサイトリンクは表示しないで」ってGoogleにお願いできたんだよね。 すごく便利だったんだけど、その機能はもう廃止されちゃった。 だから、もし変なページ…例えば、もう更新してない古いキャンペーンページとかがサイトリンクに出ても、基本は我慢するしかない、というか、根本原因を探るしかない。

Googleの公式ヘルプ見ても、基本は「ユーザーにとって有益かどうか」っていう話なんだけど、日本のサイトを見てると、やっぱり「会社概要」とか「アクセス」は出やすい気がするんだよね。海外のサイトだと『About Us』はもちろんあるけど、それと同じくらい『Careers』とか『Press』が強かったりする。多分、日本のユーザーが企業サイトを見るとき、まず「ちゃんとした会社か?」って確認する文化があるから、そこをGoogleが読み取ってるんじゃないかなって。これは僕の推測だけどね。公式な情報じゃないけど、肌感覚としてそう思う。

どうしても変なサイトリンクを消したい時の最後の手段

じゃあ、本当に困ったときはどうするか。最後の、ほんとうに最後の手段がいくつかある。

| 対策方法 | どんな時に使うか | 個人的な注意点 |

|---|---|---|

| ページ自体を削除する (404) | もうそのページが全く不要な場合。 | 一番手っ取り早いけど、当たり前だけどそのページはもう見れなくなる。他のページからのリンクも切れるから注意。 |

| noindexタグを入れる | ページは残したいけど、検索結果には出したくない場合。 | これが一番現実的かな。サイトリンクから消えるだけじゃなくて、検索結果全体から消えるから、そこは覚悟の上で。 でも、他のサイトからリンクされてると、完全には消えないこともあるから…厄介なんだよね。 |

| Search Consoleの一時的な削除ツール | 本当に緊急で、1秒でも早く検索結果から隠したい場合。 | これはあくまで「一時的」。 根本解決にはならないし、約6ヶ月後にはまた表示される可能性がある。 個人情報が漏れちゃった、とかそういうレベルの緊急事態用だと思った方がいい。 |

個人的には、変なサイトリンクが出るってことは、サイトの構造か、ユーザーの動きに何か意図しない問題があるってサインだと思うんだよね。だから、安易にnoindexとかに頼る前に、「なんでこのページが重要だとGoogleは判断したんだろう?」って考えてみるのが、遠回りなようで一番の近道だと思う。

よくある勘違い

最後に、よくある勘違いをひとつ。リスティング広告の「サイトリンク表示オプション」と、オーガニック検索のサイトリンクは全くの別物だということ。 広告の方は、お金を払って自分で好きなリンクを設定できる。 でも、今回話してる自然検索のサイトリンクは、さっきから言ってる通り、Googleが自動で決めるもの。 ここ、ごっちゃにしないようにね。

…と、まあ、こんな感じかな。サイトリンクはコントロールできないからこそ、面白いというか、奥が深いというか。結局は、ちゃんとユーザーの方を向いてサイトを作ってるかどうかが問われるってことなんだと思う。うん。疲れたから、今日はこのへんで。