XMLサイトマップ、ちゃんとやってる?

XMLサイトマップ。…まあ、みんな作ってるよね。でも、正直なところ、ただ作って送信してるだけ、になってない? [作っただけ]じゃ、あんまり意味ないかも。クロール効率を上げる、っていうのが本来の目的なんだから。

Googleに「ここ見てね」って地図を渡すようなもの。でも、その地図が古かったり、ごちゃごちゃしてたら、逆に迷わせちゃう。だから、ちゃんとした「最適化」がいる。そこ、結構深い話。

まず結論。何が一番大事?

結局、一番大事なのは「正確な`

だから、フォーカスすべきはそこじゃない。いかに「正直な」サイトマップを作るか。更新してないページを更新したって嘘をつくと、Googleに信用されなくなる。 これ、肝に銘じといたほうがいい。

じゃあ、具体的にどうやるの? [実践ポイント]

じゃあ、どう最適化していくか。いくつかポイントがある。ただツールで自動生成するだけじゃなくて、一手間かける感じ。

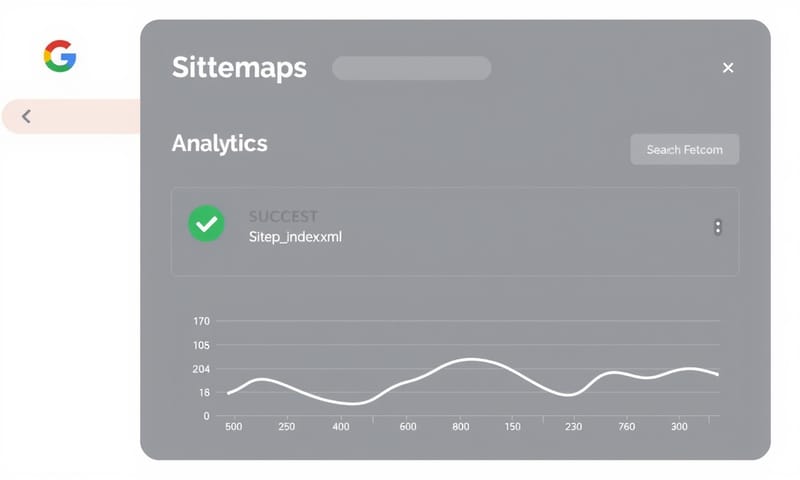

送信設定:Search Consoleだけじゃない

まず、どうやってGoogleに知らせるか。ほとんどの人はSearch Consoleから手動で送信してると思う。 それで基本はOK。でも、他にも方法がある。

- robots.txtに記述する: `Sitemap: https://example.com/sitemap.xml` って一行書くだけ。 これなら、クローラーが来た時に勝手に見つけてくれる。一番楽かも。

- Ping送信: これは、更新した時に「更新したよ!」って能動的にGoogleに通知する方法。スクリプト組めるなら自動化もできる。ただ、やり過ぎは注意。

個人的には、robots.txtへの記述はマストでやっておいて、大きな更新があった時だけSearch Consoleから再送信する、くらいがいいバランスかなと思ってる。 手間と効果のバランス。

更新頻度:「いつ」「何を」更新するか

ここが一番のキモ。`

重要なのは、ページのコンテンツが「実質的に更新された」時に、`

WordPressを使ってるなら、最近のバージョン(5.5以降)は標準でサイトマップを生成してくれるし、`lastmod`もちゃんと入れてくれるみたい。 プラグインに頼りっきりだった人も、一度標準の機能を確認してみるといいかもね。

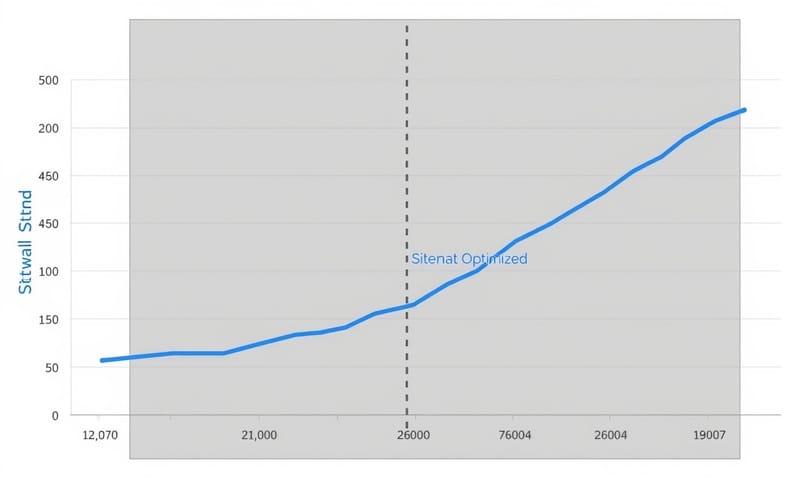

サイトの規模と種類でやることは変わる?

もちろん、変わる。100ページのブログと100万点の商品があるECサイトじゃ、戦略が全然違う。

- 小規模サイト (~500ページ): 正直、そこまで神経質にならなくてもいい。WordPressの標準機能やプラグインで生成されるサイトマップを、Search Consoleに登録しておけば十分。 大事なのは、noindexページとかを含めないように、ちゃんと設定を確認すること。

- 大規模サイト (1万ページ~): ここからが本番。まず、サイトマップは分割しないとダメ。 1ファイルあたり50,000URLか50MBっていう上限があるから。 `sitemap_index.xml`を使って、カテゴリー別(商品、ブログ記事など)にファイルをまとめるのが一般的。

- ニュースサイト・求人サイト: ここは鮮度が命。サイトマップの更新だけじゃ追いつかない。Googleの「Indexing API」を使うべき。 これを使うと、記事を公開したり更新したりした瞬間にGoogleに通知できる。サイトマップよりずっと速い。 ただし、使えるページの種類が限定されてるから注意。 今のところ、求人情報(JobPosting)とライブ配信動画(BroadcastEvent)だけが公式の対象。

サイトマップ生成ツールの選び方、雑感

ツールも色々あるけど、どれ使えばいいのか。ちょっと整理してみる。

| 生成方法 | メリット | デメリット・所感 | ||

|---|---|---|---|---|

| WordPressプラグイン (例: XML Sitemaps) | まあ、一番楽だよね。インストールして有効化すれば、ほぼ自動。 細かい設定もできる。 | 設定をちゃんと見ないと、不要なページ(タグページとか)まで含んじゃうことがある。 あと、プラグイン同士の相性問題も稀にあるかな。 | ||

| オンライン生成ツール | WordPressじゃないサイトでも使える。URL入れるだけで作ってくれるから手軽。 | 静的なファイルしか作れないことが多い。 サイトを更新するたびに、手動で作り直してアップロードする必要がある。…面倒くさい。 | ||

| カスタムスクリプト | 一番自由度が高い。ECサイトで在庫と連動させるとか、複雑なことできる。動的生成も可能。 | 開発コストがかかる。当たり前だけど。専門知識がないと無理。メンテナンスも自分でやらないといけない。 |

よくある間違いと誤解 [これやっちゃダメ]

最後に、よく見かける間違いをいくつか。

- `noindex`ページを含めている: 絶対ダメ。 サイトマップは「インデックスしてほしいページ」のリスト。矛盾してる。クローラーを混乱させるだけ。

- 404やリダイレクトURLが残っている: サイトを整理したら、サイトマップからも消す。 存在しないページの地図を渡しても意味ないから。Screaming Frogみたいなツールで定期的にチェックするといい。

- `

`の数値を必死に調整する : だから、もう意味ないって。 そこに時間使うなら、良いコンテンツを1本書いたほうがいい。 - 更新してないのに`

`を全部今日の日付にする : これ最悪。Googleからの信頼を失う。 正直が一番。

結局、サイトマップ最適化って、派手なテクニックじゃない。地味だけど、サイトの「今」を正直に、丁寧にGoogleに伝えるための作業。それをちゃんとやるだけで、クローラーは迷わなくなる。それが、巡り巡ってSEOにも効いてくる、ってことなんだと思う。

あなたのサイトのサイトマップ、どうなってる?プラグイン任せ?それとも、何か特別な工夫、してる?